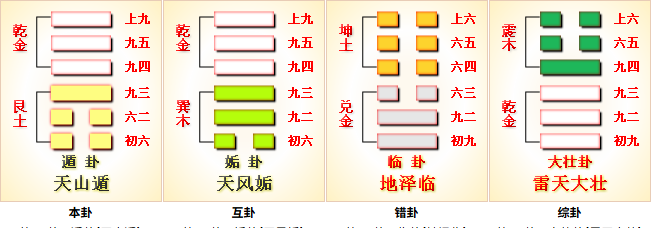

雷天大壮

大壮卦,下(内)乾(天、健)上(外)震(雷、动),为十二消息卦之一,阴消阳息,阳长阴退,为阳气大盛之时。大壮,大者壮也,刚爻为大,柔爻为小。大壮则止,大壮是刚爻壮大(四个刚爻,两个柔爻),是较好的格局,在往前就要物极必反,因此要止。天山遁为退,雷天大壮为止。

易 彖 彖曰:大壮,大者壮也。刚以动,故壮。大壮利贞,大者正也。正大而天地之请可见矣。

象 初九 易 象 初九阳居阳位,最下最外,刚健尚浅、根基未稳;上无应,却与九四同性相敌,一动即触刚,故戒“征凶”。虽有孚诚,但位卑力孤,信亦“穷”而无所施;时机不成熟,故宜蓄力,不宜速进。

古人注解 :

王弼

以刚居初,壮而未得其正,故壮于趾也。动则凶。

程颐

壮而未中,轻躁于动,故征凶。

趾者,始也。始而遽壮,其志虽诚,终不可济。

九二 易 象 九二刚爻居中,上有六五为正应,得中又有应援,贞吉。

九三 易 象

小人用壮,君子用罔,贞厉 : 罔,无、不、空。小人会用强盛的力量去逞强妄动,君子则宁愿放弃。羝羊触藩,羸其角 : 羝羊,公羊,以好斗、刚猛著称。藩,藩篱、篱笆、围栏。羸,卡断、损伤、受制、疲弱。公羊硬撞藩篱、角被卡住的具象,象征刚健过盛致凶。力量强大却不知审时度势,鲁莽行事,最终力量反而成了自身的桎梏。

九三处下卦乾之终,刚亢过中,大壮至三,阳气极盛,最易“恃壮为暴”。对应上六,动而上撞,正犯“藩篱”,故取“羝羊”为象。小人得此位,必“用壮”,以力服人,终撞墙折角;君子知“罔”,不用其壮,知止不乱、大智若愚,反得自全。

古人注解 :

王弼

刚过不中,动而用壮,则陷于危。

程颐

壮而不知止,故触藩而困。

以壮处壮之时,故小人用壮。君子知其险,不敢也。

九四 易 象

藩决不羸,壮于大舆之輹 : 决,破裂、破除。輹,伏兔,大车厢下的横木、轮轴,起固定和承重作用。篱笆(藩)已经被冲破,公羊的角就不会被困住。力量强大得像大车轮子下托住轴的木块(輹),坚固而稳定。

九四阳居阴位,刚而得柔,阳刚之力用于“车輹”,比喻刚而得用,可行远载重。下乘九三之“触藩”,上接六五之柔主,刚柔相济、时位得宜,刚健而动,正是“破藩出困”的转折点。时机已转,可以向前。

古人注解 :

六五 易 象

丧羊于易 : 丧,失去、丢失,此处指主动舍弃。羊,在大壮卦中指刚爻。易,通埸(yì),田畔、边界、疆场,也含有轻易之意。

六五以阴居阳位,处全卦之尊,正是“位不当”;但得中,且正应九二,有“以柔克刚”之象。大壮至五,阳气已达极点,象征着在强盛的阳刚时期,以柔弱、谦和的方式居于君位。六五以柔弱之质居君位,本有“失位”之悔。但它懂得适时放弃刚猛,以柔顺中和之道应对大壮之势,因此无悔。

古人注解 :

王弼

羊者,刚也。六五以阴居尊,不宜用刚,故宜丧羊也。

程颐

处尊位而不能以刚,舍其刚乃得无悔。

以柔居尊,不当用壮。丧其壮则无悔。

上六 易 象 象曰: 不能退,不能遂,不详也;艰则吉,咎不长也。

羝羊触藩,不能退,不能遂,无悠利 : 羝羊,公羊,指过盛之刚。遂,前进、顺遂。刚猛力量使用过度的最终下场是进退失据,陷入绝境。唯一的出路是接受并经受艰难困苦,耐心解角、徐徐退身,虽艰而终脱;

上六居大壮之终,震动之极;刚已过极,反被其困,成“角卡藩中”之象。九三是 “刚健过盛、主动逞强” 致困,卡得不深,还能救;上六是 “刚健终局、势尽难返” 致困,进退维谷、左右为难。不详 即 “缺乏远见、行事不审”,在刚健盛长时未及时收敛(如六五 “丧羊” 的取舍),最终陷入终局困局。

古人注解 :

王弼

过刚而穷,故不能退,不能遂。

程颐

壮极则穷,能知其艰而止,自可得吉。

柔居上位,不能任壮,强用之必困。